¡En tendencia! El gran modelo de Meituan se vuelve popular gracias a su "rapidez"

Desarrolladores nacionales e internacionales: ¡Probado personalmente, el nuevo modelo open source de Meituan es súper rápido!

Cuando la IA realmente se vuelve tan común como el agua y la electricidad, la potencia del modelo ya no es la única preocupación de todos.

Desde Claude 3.7 Sonnet y Gemini 2.5 Flash a principios de año, hasta los recientes GPT-5 y DeepSeek V3.1, todos los fabricantes de modelos líderes están pensando: ¿cómo lograr que la IA, manteniendo la precisión, resuelva cada problema con el menor poder de cómputo posible y responda en el menor tiempo? En otras palabras, ¿cómo evitar desperdiciar tokens y tiempo?

Para las empresas y desarrolladores que construyen aplicaciones sobre modelos, este cambio de “simplemente construir el modelo más potente” a “construir modelos más prácticos y rápidos” es una buena noticia. Y lo que es aún más alentador, es que los modelos open source relacionados también están aumentando gradualmente.

Hace unos días, encontramos un nuevo modelo en HuggingFace: LongCat-Flash-Chat.

Este modelo proviene de la serie LongCat-Flash de Meituan, y se puede usar directamente en su sitio web oficial.

Naturalmente comprende que “no todos los tokens son iguales”, por lo que asigna dinámicamente presupuesto de cómputo a los tokens importantes según su relevancia. Esto le permite, activando solo una pequeña cantidad de parámetros, igualar el rendimiento de los modelos open source líderes actuales.

LongCat-Flash se volvió tendencia tras su lanzamiento open source.

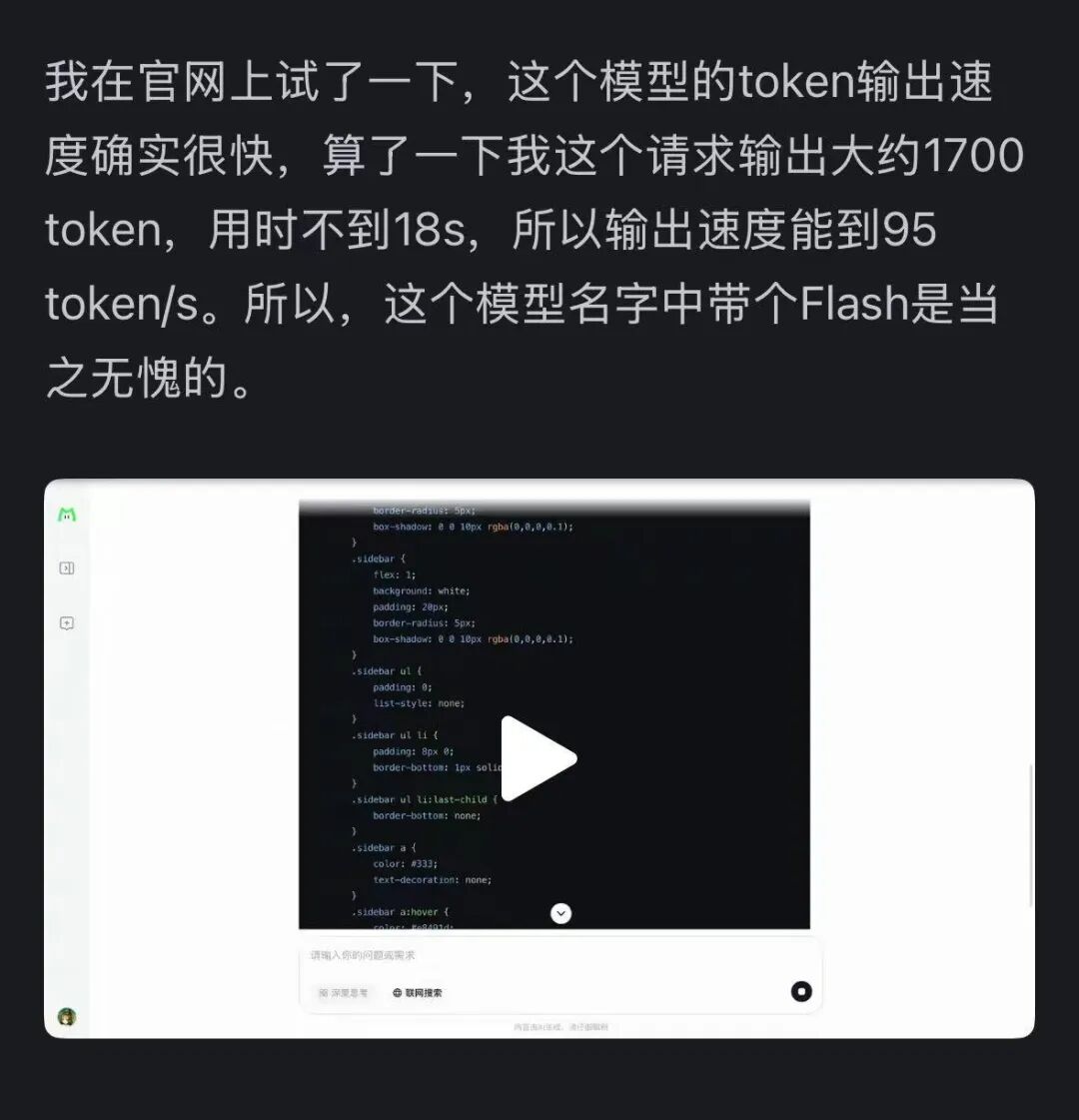

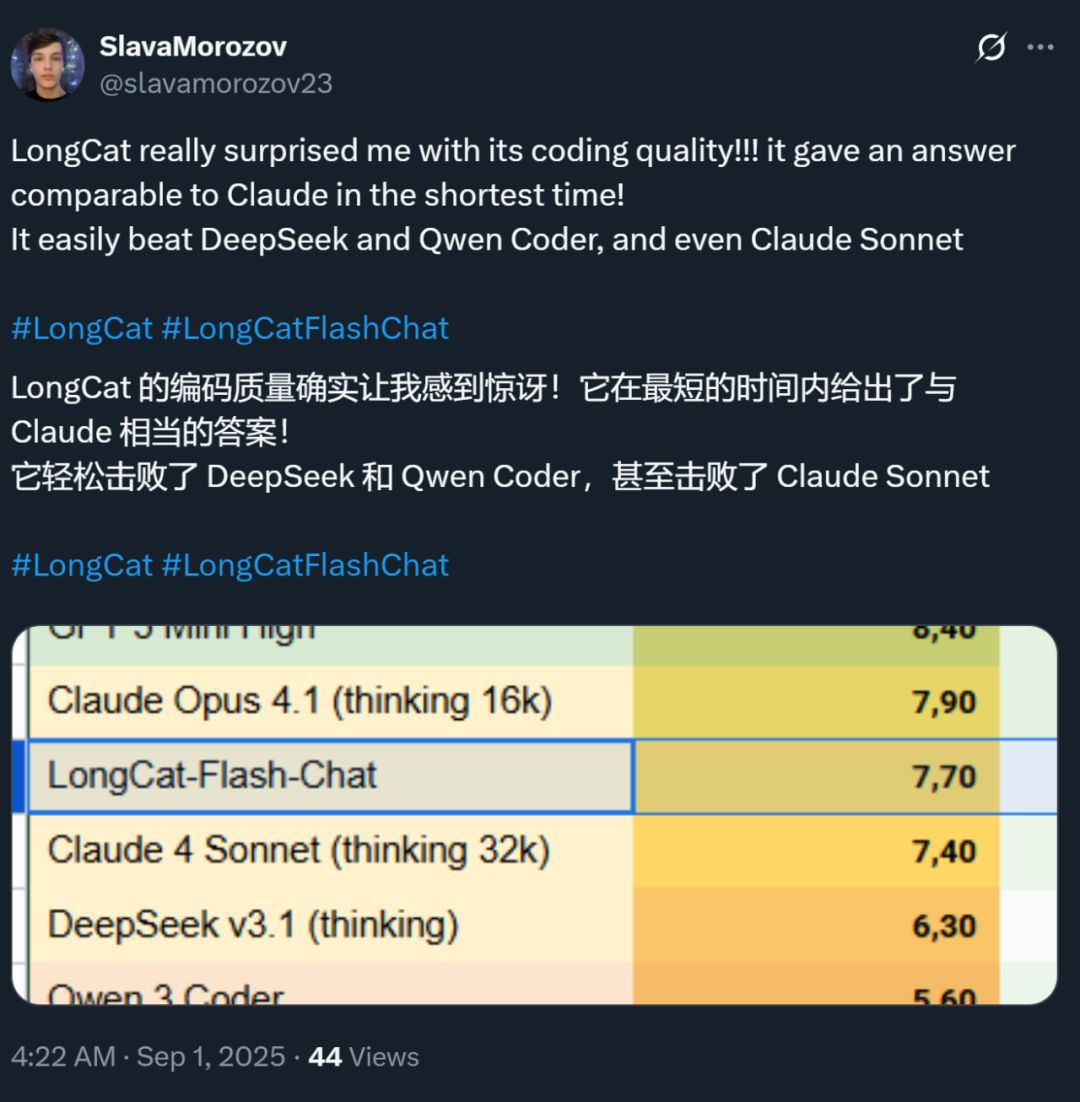

Al mismo tiempo, la velocidad de este modelo también ha dejado una profunda impresión: en la tarjeta gráfica H800, la velocidad de inferencia supera los 100 tokens por segundo. Las pruebas de desarrolladores nacionales e internacionales lo confirman: algunos lograron 95 tokens/s, otros obtuvieron respuestas comparables a Claude en el menor tiempo posible.

Fuente de la imagen: usuario de Zhihu @小小将.

Fuente de la imagen: usuario de X @SlavaMorozov.

Junto con el modelo open source, Meituan también publicó el informe técnico de LongCat-Flash, donde se pueden ver muchos detalles técnicos.

Informe técnico: LongCat-Flash Technical Report

En este artículo, lo presentaremos en detalle.

¿Cómo ahorra cómputo un gran modelo?

Veamos la innovación arquitectónica y los métodos de entrenamiento de LongCat-Flash

LongCat-Flash es un modelo de expertos mixtos con un total de 560 mil millones de parámetros, capaz de activar entre 18.6 y 31.3 mil millones (promedio 27 mil millones) de parámetros según las necesidades del contexto.

La cantidad de datos utilizada para entrenar este modelo supera los 20 trillones de tokens, pero el tiempo de entrenamiento fue de menos de 30 días. Además, durante este tiempo, el sistema alcanzó una disponibilidad del 98.48%, casi sin necesidad de intervención humana para manejar fallos, lo que significa que todo el proceso de entrenamiento fue prácticamente “sin intervención humana” y completamente automático.

Aún más impresionante es que el modelo entrenado de esta manera también se desempeña excelentemente en el despliegue real.

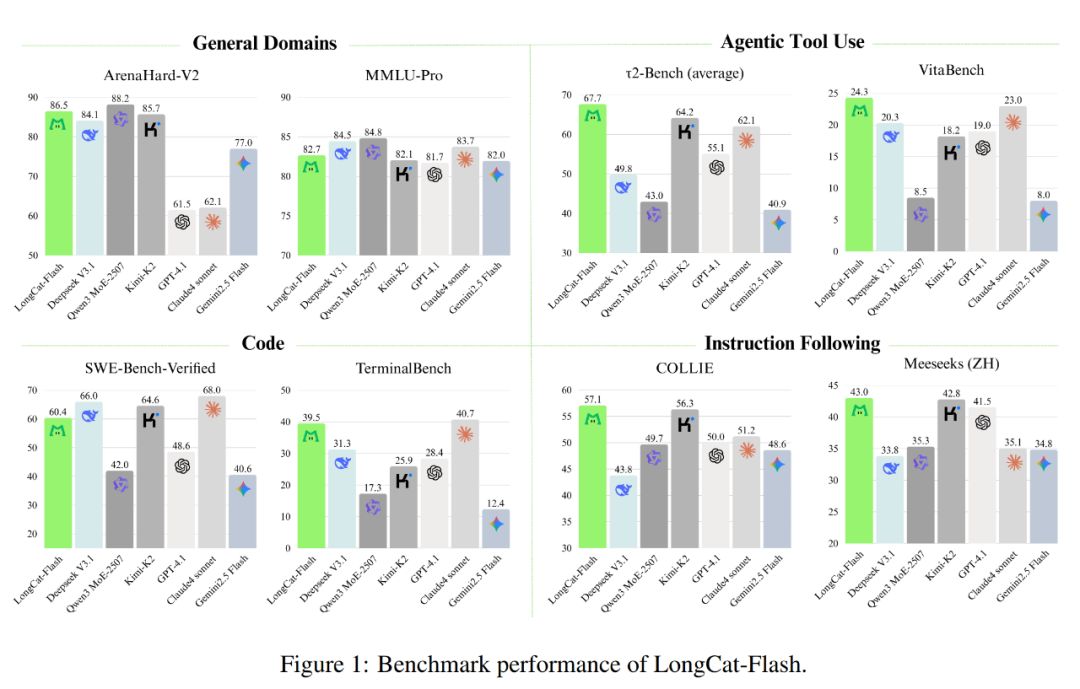

Como se muestra en la imagen siguiente, como modelo no reflexivo, LongCat-Flash logra un rendimiento comparable a los modelos SOTA no reflexivos, incluyendo DeepSeek-V3.1 y Kimi-K2, con menos parámetros y mayor velocidad de inferencia. Esto lo hace muy competitivo y práctico en áreas como uso general, programación y herramientas de agentes inteligentes.

Además, su costo es muy atractivo, siendo de 0.7 dólares por cada millón de tokens generados. Este precio es muy competitivo en comparación con modelos de escala similar en el mercado.

Técnicamente, LongCat-Flash apunta principalmente a dos objetivos de los modelos de lenguaje: eficiencia computacional y capacidad de agente inteligente, fusionando innovación arquitectónica y métodos de entrenamiento en múltiples etapas para lograr un sistema de modelos escalable e inteligente.

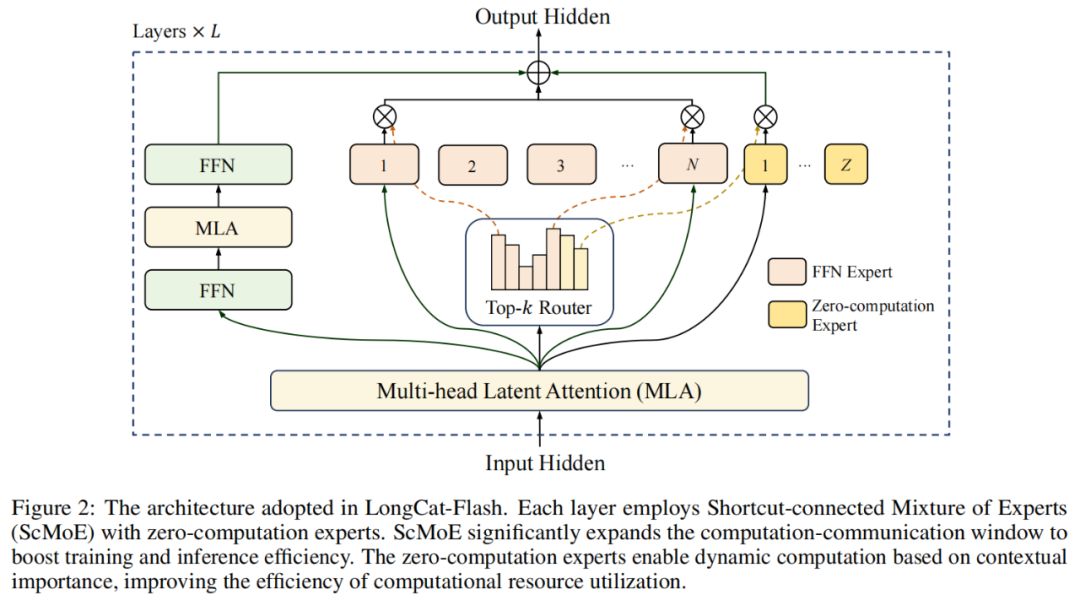

En cuanto a la arquitectura del modelo, LongCat-Flash adopta una novedosa arquitectura MoE (Figura 2), cuyos puntos destacados incluyen:

Expertos de cero cómputo (Zero-computation Experts);

MoE con conexiones rápidas (Shortcut-connected MoE, ScMoE).

Expertos de cero cómputo

La idea central de los expertos de cero cómputo es que no todos los tokens son “iguales”.

Podemos entenderlo así: en una oración, algunas palabras son muy fáciles de predecir, como “de” o “es”, que casi no requieren cómputo, mientras que otras como nombres propios requieren mucho cálculo para predecirse correctamente.

En investigaciones previas, generalmente se adoptaba este enfoque: sin importar si el token es simple o complejo, siempre se activaba un número fijo (K) de expertos, lo que generaba un gran desperdicio de cómputo. Para los tokens simples, no era necesario llamar a tantos expertos, y para los complejos, podría faltar suficiente asignación de cómputo.

Inspirado por esto, LongCat-Flash propone un mecanismo de asignación dinámica de recursos computacionales: mediante expertos de cero cómputo, activa dinámicamente diferentes cantidades de expertos FFN (Feed-Forward Network) para cada token, asignando así el cómputo de manera más razonable según la importancia contextual.

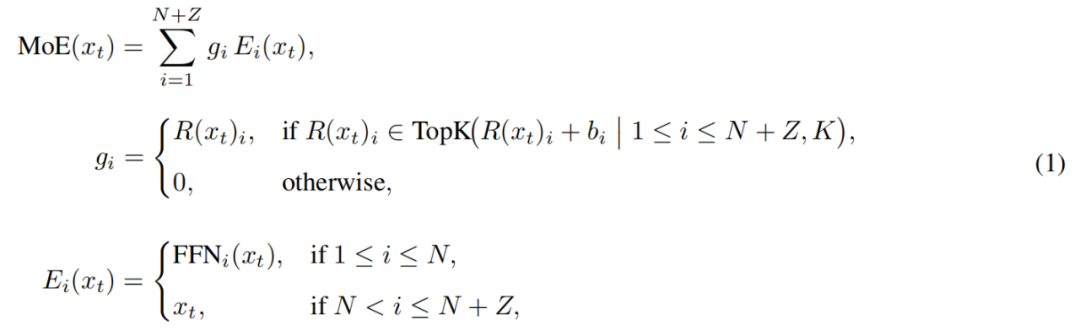

En concreto, LongCat-Flash amplía su pool de expertos, además de los N expertos FFN estándar, con Z expertos de cero cómputo. Estos expertos simplemente devuelven la entrada tal cual como salida, sin añadir carga computacional extra.

El módulo MoE en LongCat-Flash puede formalizarse como:

Donde x_t es el t-ésimo token de la secuencia de entrada, R representa el router softmax, b_i es el sesgo del i-ésimo experto, y K es el número de expertos seleccionados por token. El router asigna cada token a K expertos, y la cantidad de expertos FFN activados varía según la importancia contextual del token. Gracias a este mecanismo adaptativo, el modelo aprende a asignar más recursos computacionales a los tokens más importantes, logrando un mejor rendimiento con la misma cantidad de cómputo, como se muestra en la Figura 3a.

Además, el modelo debe aprender, al procesar la entrada, a decidir si gastar más recursos computacionales según la importancia de cada token. Si no se controla la frecuencia con la que se seleccionan los expertos de cero cómputo, el modelo podría tender a elegir expertos con cómputo, ignorando el papel de los expertos de cero cómputo, lo que resultaría en baja eficiencia de recursos.

Para resolver este problema, Meituan mejoró el mecanismo de sesgo de expertos en la estrategia aux-loss-free: introdujo un sesgo específico para cada experto, que puede ajustar dinámicamente la puntuación de enrutamiento según el uso reciente del experto, manteniéndose desacoplado del objetivo de entrenamiento del modelo de lenguaje.

La regla de actualización utiliza un controlador PID de la teoría de control para ajustar en tiempo real el sesgo de los expertos. Gracias a esto, el modelo, al procesar cada token, solo necesita activar entre 18.6 y 31.3 mil millones de parámetros (con una activación promedio estable de unos 27 mil millones), logrando una configuración óptima de recursos.

MoE con conexiones rápidas

Otro punto destacado de LongCat-Flash es el mecanismo MoE con conexiones rápidas.

Generalmente, la eficiencia de los modelos MoE a gran escala está muy limitada por los costos de comunicación. En el paradigma tradicional, la paralelización de expertos introduce un flujo de trabajo secuencial: primero se realiza una operación de comunicación global para enrutar los tokens a sus expertos asignados y luego comienza el cálculo.

Esta secuencia de primero comunicar y luego calcular añade tiempos de espera, especialmente en el entrenamiento distribuido a gran escala, donde la latencia de comunicación se convierte en un cuello de botella de rendimiento.

Investigadores previos intentaron aliviar este problema con arquitecturas de expertos compartidos, superponiendo la comunicación con el cálculo de un solo experto, pero la eficiencia estaba limitada por el pequeño tamaño de la ventana de cálculo de cada experto.

Meituan superó esta limitación introduciendo la arquitectura ScMoE, que añade una conexión rápida entre capas, permitiendo que el cálculo del FFN denso de la capa anterior se ejecute en paralelo con la comunicación de distribución/agregación de la capa MoE actual. Esto crea una ventana de solapamiento comunicación-cálculo mucho mayor que la arquitectura de expertos compartidos.

Esta arquitectura ha sido validada en múltiples experimentos.

Primero, el diseño ScMoE no reduce la calidad del modelo. Como se muestra en la Figura 4, la curva de pérdida de entrenamiento del modelo con ScMoE es casi idéntica a la del modelo base sin ScMoE, demostrando que este reordenamiento no daña el rendimiento. Esta conclusión se verifica en diversas configuraciones.

Aún más importante, estos resultados muestran que la estabilidad y ventajas de rendimiento de ScMoE son ortogonales a la elección específica del mecanismo de atención (es decir, se mantienen estables y beneficiosas independientemente del mecanismo de atención utilizado).

En segundo lugar, la arquitectura ScMoE proporciona grandes mejoras de eficiencia a nivel de sistema tanto en entrenamiento como en inferencia. Específicamente:

En entrenamiento a gran escala: la ventana de solapamiento ampliada permite que el cálculo de bloques previos se ejecute completamente en paralelo con la comunicación de distribución y agregación en la capa MoE, dividiendo las operaciones en bloques de grano fino a lo largo de la dimensión de tokens.

En inferencia eficiente: ScMoE soporta pipeline de solapamiento por lote único, reduciendo el tiempo teórico por token (TPOT) en casi un 50% en comparación con modelos líderes como DeepSeek-V3. Más importante aún, permite la ejecución concurrente de diferentes modos de comunicación: la comunicación de tensor paralela dentro del nodo para el FFN denso (a través de NVLink) se superpone completamente con la comunicación de expertos entre nodos (a través de RDMA), maximizando la utilización de la red.

En resumen, ScMoE proporciona grandes mejoras de rendimiento sin sacrificar la calidad del modelo.

Estrategia de expansión del modelo y entrenamiento en múltiples etapas

Meituan también propuso una estrategia eficiente de expansión del modelo, que mejora significativamente el rendimiento al aumentar la escala del modelo.

Primero, la transferencia de hiperparámetros: al entrenar modelos de ultra gran escala, probar directamente varias configuraciones de hiperparámetros es costoso e inestable. Por ello, Meituan primero experimenta en modelos más pequeños para encontrar la mejor combinación de hiperparámetros y luego los transfiere al modelo grande, ahorrando costos y asegurando resultados. Las reglas de transferencia se muestran en la Tabla 1:

Luego, la inicialización de crecimiento del modelo: Meituan comienza con un modelo a media escala preentrenado en decenas de miles de millones de tokens, guarda el checkpoint tras el entrenamiento y lo expande a escala completa para continuar el entrenamiento.

Con este método, el modelo muestra una curva de pérdida típica: la pérdida sube brevemente, luego converge rápidamente y finalmente supera significativamente la línea base de inicialización aleatoria. La Figura 5b muestra un resultado representativo en el experimento de 6B parámetros activados, demostrando la ventaja de la inicialización de crecimiento.

El tercer punto es un kit de estabilidad multinivel: Meituan mejoró la estabilidad de entrenamiento de LongCat-Flash desde la estabilidad del router, la activación y el optimizador.

El cuarto punto es el cálculo determinista, que garantiza la reproducibilidad total de los resultados experimentales y permite detectar la corrupción silenciosa de datos (Silent Data Corruption, SDC) durante el entrenamiento.

Gracias a estas medidas, el entrenamiento de LongCat-Flash se mantiene altamente estable, sin picos de pérdida irrecuperables.

Sobre la base de la estabilidad de entrenamiento, Meituan también diseñó cuidadosamente el pipeline de entrenamiento, dotando a LongCat-Flash de comportamientos avanzados de agente inteligente. Este proceso abarca preentrenamiento a gran escala, entrenamiento intermedio enfocado en razonamiento y habilidades de código, y post-entrenamiento centrado en diálogo y uso de herramientas.

En la etapa inicial, se construye un modelo base más adecuado para el post-entrenamiento de agentes inteligentes. Para ello, Meituan diseñó una estrategia de fusión de datos de preentrenamiento en dos etapas para concentrar datos de dominios intensivos en razonamiento.

En la etapa intermedia, Meituan refuerza aún más la capacidad de razonamiento y de código del modelo, y extiende la longitud de contexto a 128k para satisfacer las necesidades del post-entrenamiento de agentes inteligentes.

Finalmente, Meituan realiza un post-entrenamiento en múltiples etapas. Dada la escasez de datos de entrenamiento de alta calidad y dificultad en el ámbito de agentes inteligentes, Meituan diseñó un marco de síntesis multiagente: este marco define la dificultad de las tareas en tres dimensiones: procesamiento de información, complejidad del conjunto de herramientas e interacción con el usuario, utilizando un controlador especializado para generar tareas complejas que requieren razonamiento iterativo e interacción con el entorno.

Este diseño le permite destacar en tareas complejas que requieren el uso de herramientas y la interacción con el entorno.

Corre rápido y es barato

¿Cómo lo logra LongCat-Flash?

Como se mencionó antes, LongCat-Flash puede inferir a más de 100 tokens por segundo en la tarjeta H800, con un costo de solo 0.7 dólares por cada millón de tokens generados; es decir, es rápido y barato.

¿Cómo lo logran? Primero, tienen una arquitectura de inferencia paralela diseñada en conjunto con la arquitectura del modelo; segundo, han incorporado métodos de optimización como cuantización y kernels personalizados.

Optimización exclusiva: hacer que el modelo “corra solo”

Sabemos que para construir un sistema de inferencia eficiente, hay que resolver dos problemas clave: la coordinación entre cómputo y comunicación, y la lectura/escritura y almacenamiento de la caché KV.

Para el primer desafío, los métodos existentes suelen aprovechar la paralelización en tres niveles: solapamiento a nivel de operador, de experto y de capa. La arquitectura ScMoE de LongCat-Flash introduce un cuarto nivel: solapamiento a nivel de módulo. Para ello, el equipo diseñó la estrategia de programación SBO (Single Batch Overlap) para optimizar la latencia y el rendimiento.

SBO es una ejecución en pipeline de cuatro etapas que aprovecha al máximo el potencial de LongCat-Flash mediante el solapamiento a nivel de módulo, como se muestra en la Figura 9. A diferencia de TBO, SBO oculta el costo de comunicación dentro de un solo lote. En la primera etapa se realiza el cálculo MLA, proporcionando la entrada para las siguientes etapas; la segunda etapa solapa el FFN denso y Attn 0 (proyección QKV) con la comunicación all-to-all dispatch; la tercera etapa ejecuta MoE GEMM de forma independiente, beneficiándose de una amplia estrategia de despliegue EP; la cuarta etapa solapa Attn 1 (atención central y proyección de salida) y FFN denso con all-to-all combine. Este diseño alivia eficazmente el costo de comunicación y garantiza la inferencia eficiente de LongCat-Flash.

Para el segundo desafío —lectura/escritura y almacenamiento de la caché KV— LongCat-Flash lo resuelve mediante su mecanismo de atención y la innovación arquitectónica de MTP, reduciendo el costo efectivo de I/O.

Primero, aceleración de decodificación especulativa. LongCat-Flash utiliza MTP como modelo borrador, optimizando tres factores clave mediante el análisis del sistema y la fórmula de aceleración de decodificación especulativa: longitud de aceptación esperada, relación de costo entre modelo borrador y objetivo, y relación de costo entre verificación y decodificación del objetivo. Integrando una sola cabeza MTP e introduciéndola en la etapa final del preentrenamiento, se logra una tasa de aceptación de aproximadamente el 90%. Para equilibrar calidad y velocidad del borrador, se utiliza una arquitectura MTP ligera para reducir parámetros y el método C2T para filtrar tokens poco probables mediante un modelo de clasificación.

En segundo lugar, optimización de la caché KV, lograda mediante el mecanismo de atención de 64 cabezas de MLA. MLA equilibra rendimiento y eficiencia, reduce significativamente la carga computacional y logra una excelente compresión de la caché KV, aliviando la presión de almacenamiento y ancho de banda. Esto es clave para coordinar el pipeline de LongCat-Flash, ya que el modelo siempre tiene cálculos de atención que no pueden solaparse con la comunicación.

Optimización a nivel de sistema: hacer que el hardware “trabaje en equipo”

Para minimizar el costo de programación, el equipo de LongCat-Flash resolvió el problema launch-bound causado por el costo de inicio del kernel en los sistemas de inferencia LLM. Especialmente tras introducir la decodificación especulativa, la programación independiente del kernel de verificación y del borrador genera un costo significativo. Mediante la estrategia de fusión TVD, fusionaron la inferencia objetivo, la verificación y la inferencia del borrador en un solo gráfico CUDA. Para mejorar aún más la utilización de la GPU, implementaron un programador solapado e introdujeron un programador de solapamiento multinivel que inicia múltiples pasos de inferencia en una sola iteración de programación, ocultando eficazmente el costo de programación y sincronización de la CPU.

La optimización de kernels personalizados aborda los desafíos de eficiencia únicos de la inferencia autoregresiva en LLM. La etapa de pre-relleno es intensiva en cómputo, mientras que la etapa de decodificación suele estar limitada por la memoria debido al tamaño pequeño e irregular de los lotes generado por el patrón de tráfico. Para MoE GEMM, utilizaron la técnica SwapAB, considerando los pesos como la matriz izquierda y las activaciones como la derecha, maximizando la utilización del núcleo tensorial con granularidad de 8 elementos en la dimensión n. El kernel de comunicación aprovecha la aceleración de hardware de NVLink Sharp para broadcast y reducción in-switch, minimizando el movimiento de datos y la ocupación de SM, superando consistentemente a NCCL y MSCCL++ con solo 4 bloques de hilos en un rango de tamaño de mensaje de 4KB a 96MB.

En cuanto a la cuantización, LongCat-Flash adopta el mismo esquema de cuantización por bloques de grano fino que DeepSeek-V3. Para lograr el mejor equilibrio entre rendimiento y precisión, implementa una cuantización mixta por capas basada en dos esquemas: el primero identifica que ciertas capas lineales (especialmente Downproj) tienen activaciones de entrada con magnitudes extremas de hasta 10^6; el segundo calcula el error de cuantización FP8 por bloque en cada capa, encontrando errores significativos en capas de expertos específicas. Al tomar la intersección de ambos esquemas, se logra una mejora significativa en la precisión.

Datos prácticos: ¿qué tan rápido y barato puede correr?

El rendimiento real muestra que LongCat-Flash se desempeña excelentemente en diferentes configuraciones. En comparación con DeepSeek-V3, con longitudes de contexto similares, LongCat-Flash logra mayor throughput y velocidad de generación.

En aplicaciones de agentes, considerando las diferentes necesidades de inferencia (contenido visible para el usuario, que debe igualar la velocidad de lectura humana de unos 20 tokens/s, y comandos de acción, invisibles para el usuario pero que afectan directamente el tiempo de inicio de herramientas y requieren la máxima velocidad), la velocidad de generación de casi 100 tokens/s de LongCat-Flash mantiene la latencia de una sola llamada de herramienta en menos de 1 segundo, mejorando significativamente la interactividad de las aplicaciones de agentes. Bajo el supuesto de un costo de 2 dólares por hora para la GPU H800, esto significa un precio de 0.7 dólares por cada millón de tokens generados.

El análisis teórico de rendimiento muestra que la latencia de LongCat-Flash está determinada principalmente por tres componentes: MLA, all-to-all dispatch/combine y MoE. Bajo los supuestos de EP=128, batch por tarjeta=96, tasa de aceptación MTP≈80%, el TPOT teórico límite de LongCat-Flash es de 16ms, significativamente mejor que los 30ms de DeepSeek-V3 y los 26.2ms de Qwen3-235B-A22B. Bajo el supuesto de 2 dólares por hora para la GPU H800, el costo de salida de LongCat-Flash es de 0.09 dólares por cada millón de tokens, muy por debajo de los 0.17 dólares de DeepSeek-V3. Sin embargo, estos valores son solo límites teóricos.

También probamos en la página de experiencia gratuita de LongCat-Flash.

Primero le pedimos a este gran modelo que escribiera un artículo sobre el otoño, de unas 1000 palabras.

En cuanto hicimos la solicitud y abrimos la grabación de pantalla, LongCat-Flash ya había generado la respuesta, ni siquiera tuvimos tiempo de detener la grabación a tiempo.

Si observas con atención, notarás que la velocidad de salida del primer token de LongCat-Flash es especialmente rápida. Con otros modelos de diálogo, a menudo hay que esperar, lo que pone a prueba la paciencia del usuario, como cuando quieres ver un mensaje en WeChat y el teléfono muestra “recibiendo”. LongCat-Flash cambia esta experiencia, y prácticamente no se percibe retraso en el primer token.

La velocidad de generación de los tokens posteriores también es muy rápida, superando con creces la velocidad de lectura humana.

Luego, activamos la “búsqueda en línea” para ver si LongCat-Flash es lo suficientemente rápido en esta función. Le pedimos que recomendara buenos restaurantes cerca de Wangjing.

La prueba muestra claramente que LongCat-Flash no se toma mucho tiempo para pensar antes de responder, sino que da la respuesta casi de inmediato. La búsqueda en línea también se siente “rápida”. Además, mientras responde rápidamente, puede citar fuentes, garantizando la credibilidad y trazabilidad de la información.

Los lectores que puedan descargar el modelo pueden probarlo localmente para ver si la velocidad de LongCat-Flash es igual de impresionante.

Cuando los grandes modelos entran en la era práctica

En los últimos años, cada vez que aparecía un gran modelo, todos se preocupaban: ¿cuáles son sus datos de benchmark? ¿Cuántos rankings ha batido? ¿Es SOTA? Ahora, la situación ha cambiado. Cuando las capacidades son similares, la gente se preocupa más por: ¿es caro usar este modelo? ¿Qué tan rápido es? Esto es especialmente evidente entre las empresas y desarrolladores que usan modelos open source. Muchos usuarios eligen modelos open source para reducir la dependencia y el costo de las API cerradas, por lo que son más sensibles a la demanda de cómputo, velocidad de inferencia y efectos de compresión y cuantización.

El modelo open source LongCat-Flash de Meituan es un ejemplo de esta tendencia. Se enfocan en cómo hacer que los grandes modelos sean realmente asequibles y rápidos, lo cual es clave para la popularización tecnológica.

Esta elección práctica es coherente con la percepción que siempre hemos tenido de Meituan. En el pasado, la mayoría de sus inversiones tecnológicas se han centrado en resolver problemas reales de negocio, como el artículo EDPLVO, ganador del ICRA 2022 al mejor trabajo en navegación, que en realidad resolvía problemas de drones en entregas (por ejemplo, la pérdida de señal por edificios densos); o el reciente estándar ISO global de evasión de obstáculos para drones, basado en la experiencia técnica de evitar cuerdas de cometas o cables de limpieza de ventanas durante el vuelo. El modelo open source LongCat-Flash es, de hecho, el motor detrás de su herramienta de programación AI “NoCode”, que sirve tanto a la empresa como al público de forma gratuita, con el objetivo de promover el vibe coding y lograr reducción de costos y aumento de eficiencia.

Este cambio de la competencia de rendimiento a la orientación práctica refleja la evolución natural de la industria de la IA. A medida que las capacidades de los modelos se igualan, la eficiencia de ingeniería y el costo de despliegue se convierten en factores diferenciadores clave. La apertura de LongCat-Flash es solo un ejemplo de esta tendencia, pero proporciona una ruta técnica de referencia para la comunidad: cómo reducir la barrera de uso mediante innovación arquitectónica y optimización de sistemas sin sacrificar la calidad del modelo. Esto es, sin duda, valioso para desarrolladores y empresas con presupuestos limitados que desean aprovechar capacidades avanzadas de IA.

Descargo de responsabilidad: El contenido de este artículo refleja únicamente la opinión del autor y no representa en modo alguno a la plataforma. Este artículo no se pretende servir de referencia para tomar decisiones de inversión.

También te puede gustar

¿Cuánto tienes que ganar en el mundo cripto para poder decir que has "cambiado tu destino"?

El verdadero riesgo no reside en la "pérdida", sino en "nunca saber que ya has ganado".

NBER | Revelando con modelos cómo la expansión de la economía digital está remodelando el panorama financiero global

Los resultados de la investigación muestran que, a largo plazo, el efecto de demanda de reservas predomina sobre el efecto de sustitución, lo que conduce a una reducción de las tasas de interés en Estados Unidos y a un aumento del endeudamiento externo estadounidense.

ETH toma el escenario: la verdadera apertura de la segunda mitad del mercado alcista

Combinando la estructura del mercado, los flujos de capital, los datos en cadena y el entorno regulatorio, nuestra conclusión es clara: Ethereum está reemplazando gradualmente a Bitcoin y se está convirtiendo en el activo central en la segunda mitad del mercado alcista.