Мільярдний бар’єр для AI: якісні дані, а не модель | Думка

AI може стати наступною індустрією з трильйонним обігом, але вона тихо наближається до величезного вузького місця. Поки всі змагаються за створення більших і потужніших моделей, одна велика проблема залишається майже без уваги: ми можемо залишитися без придатних навчальних даних вже за кілька років.

- AI закінчується "паливо": навчальні датасети зростають у 3,7 рази щороку, і ми можемо вичерпати світові запаси якісних публічних даних між 2026 і 2032 роками.

- Ринок маркування даних вибухає: з $3.7B (2024) до $17.1B (2030), тоді як доступ до реальних людських даних скорочується через закриті екосистеми та регуляції.

- Синтетичних даних недостатньо: петлі зворотного зв'язку та відсутність реальних нюансів роблять їх ризикованою заміною для неструктурованих, створених людьми даних.

- Влада переходить до власників даних: із комодифікацією моделей справжньою перевагою стане володіння унікальними, високоякісними датасетами.

За даними EPOCH AI, розмір навчальних датасетів для великих мовних моделей зростав приблизно у 3,7 рази щороку з 2010 року. За такої швидкості ми можемо вичерпати світові запаси якісних публічних навчальних даних десь між 2026 і 2032 роками.

Ще до того, як ми досягнемо цієї межі, вартість отримання та підготовки маркованих даних вже стрімко зростає. Ринок збору та маркування даних оцінювався у $3.77 мільярда у 2024 році, і очікується, що він зросте до $17.10 мільярда до 2030 року.

Такий вибуховий ріст вказує на очевидну можливість, але й на очевидне вузьке місце. AI-моделі настільки хороші, наскільки хороші дані, на яких вони навчені. Без масштабованого потоку свіжих, різноманітних і неупереджених датасетів ефективність цих моделей досягне плато, а їхня корисність почне знижуватися.

Тож справжнє питання не в тому, хто створить наступну велику AI-модель. А в тому, хто володіє даними і звідки вони надходитимуть?

Проблема даних для AI більша, ніж здається

Протягом останнього десятиліття інновації в AI значною мірою спиралися на публічно доступні датасети: Wikipedia, Common Crawl, Reddit, open-source репозиторії коду тощо. Але це джерело швидко висихає. Оскільки компанії обмежують доступ до своїх даних, а питання авторських прав накопичуються, AI-компанії змушені переосмислювати свої підходи. Уряди також вводять регулювання для обмеження скрапінгу даних, а громадська думка змінюється проти ідеї навчання моделей вартістю у мільярди доларів на неоплачуваному контенті, створеному користувачами.

Синтетичні дані — одна з запропонованих рішень, але це ризикована заміна. Моделі, навчені на даних, згенерованих іншими моделями, можуть призвести до петель зворотного зв'язку, галюцинацій і поступового погіршення якості. Є також питання якості: синтетичні дані часто позбавлені хаотичності й нюансів реального світу, а саме це потрібно AI-системам для ефективної роботи у практичних сценаріях.

Залишаються реальні, створені людьми дані як золотий стандарт, і їх стає все важче отримати. Більшість великих платформ, які збирають людські дані, такі як Meta, Google та X (раніше Twitter), є закритими екосистемами. Доступ обмежений, монетизований або повністю заборонений. Ще гірше, їхні датасети часто мають перекоси щодо певних регіонів, мов і демографічних груп, що призводить до упереджених моделей, які не працюють у різноманітних реальних випадках.

Коротко кажучи, індустрія AI ось-ось зіткнеться з реальністю, яку довго ігнорувала: побудувати масивну LLM — це лише половина справи. Інша половина — її "нагодувати".

Чому це справді важливо

У ланцюжку створення цінності AI є дві частини: створення моделей і отримання даних. Останні п’ять років майже всі капіталовкладення та ажіотаж були спрямовані на створення моделей. Але коли ми досягаємо меж розміру моделей, увага нарешті зміщується на іншу половину рівняння.

Якщо моделі стають комодитизованими — з open-source альтернативами, компактними версіями та апаратно-ефективними дизайнами — справжньою перевагою стають дані. Унікальні, високоякісні датасети стануть паливом, яке визначить, які моделі будуть кращими.

Вони також створюють нові форми створення цінності. Внесники даних стають стейкхолдерами. Розробники отримують доступ до свіжіших і динамічніших даних. А підприємства можуть навчати моделі, які краще відповідають їхній цільовій аудиторії.

Майбутнє AI належить постачальникам даних

Ми вступаємо в нову еру AI, де справжня влада належить тим, хто контролює дані. У міру того, як конкуренція за навчання кращих, розумніших моделей посилюється, найбільшим обмеженням буде не обчислювальна потужність. Це буде пошук даних, які є реальними, корисними та легальними для використання.

Питання зараз не в тому, чи масштабуватиметься AI, а в тому, хто забезпечить цей масштаб. Це будуть не лише дата-сайентисти. Це будуть куратори даних, агрегатори, внесники та платформи, які їх об'єднують. Саме тут лежить наступний рубіж.

Тож наступного разу, коли ви почуєте про новий рубіж у сфері штучного інтелекту, не запитуйте, хто створив модель. Запитайте, хто її навчав і звідки взялися дані. Адже зрештою майбутнє AI — це не лише про архітектуру. Це про вхідні дані.

Max Li — засновник і CEO OORT, хмарного сховища даних для децентралізованого AI. Dr. Li — професор, досвідчений інженер і винахідник з понад 200 патентами. Його досвід включає роботу над системами 4G LTE та 5G у Qualcomm Research і наукові внески в теорію інформації, машинне навчання та технологію blockchain. Він є автором книги “Reinforcement Learning for Cyber-physical Systems”, виданої Taylor & Francis CRC Press.

Відмова від відповідальності: зміст цієї статті відображає виключно думку автора і не представляє платформу в будь-якій якості. Ця стаття не повинна бути орієнтиром під час прийняття інвестиційних рішень.

Вас також може зацікавити

Від сірої зони до мейнстриму? Війна за легалізацію спортивних прогнозних ринків і майбутній ландшафт

Платформи прогнозування ринку Kalshi та Polymarket швидко розширюються в спортивному секторі, уклавши співпрацю з NHL, але стикаються з сумнівами з боку таких ліг, як NBA та NFL, а також із сильним опором з боку гральної індустрії. Одночасно вони потрапили у регуляторні та юридичні суперечки.

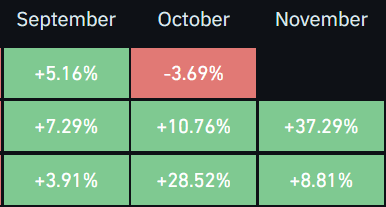

Динаміка крипторинку: чому листопад може стати наступним важливим місяцем

Крипторинок знову перейшов до бичачого тренду. Ось чому листопад 2025 року може стати ще одним сильним місяцем для Bitcoin та інших криптовалют.