Скрытая опасность ИИ: как перегруженные инструменты замедляют работу LLMs

- Серверы Model Context Protocol (MCP) позволяют LLM интегрировать внешние инструменты, однако они сталкиваются с рисками неправильного использования и снижением производительности из-за перегрузки контекстных окон. - Избыточная регистрация инструментов потребляет токены, уменьшает доступный контекст и вызывает недетерминированное поведение из-за несогласованной обработки подсказок в различных LLM. - Среди проблем безопасности — недоверенные сторонние серверы MCP, которые могут привести к атакам на цепочку поставок, что контрастирует с контролируемыми решениями от первого лица. - Такие платформы, как Northflank, упрощают развертывание MCP.

Серверы Model Context Protocol (MCP) стали ключевой инфраструктурой для разработчиков искусственного интеллекта, позволяя интегрировать внешние инструменты в большие языковые модели (LLM) для повышения их функциональности и эффективности. Эти серверы выступают в роли посредников, позволяя LLM использовать внешние источники данных или инструменты без необходимости прямого программирования или интеграции через API. Однако последние обсуждения и анализы подчеркивают растущие опасения по поводу неправильного использования, чрезмерной установки и потенциальных угроз безопасности, связанных с MCP-серверами, особенно при их развертывании без должного контроля.

Недавний блог-пост инженера Geoffrey Huntley, специализирующегося на коммерческих ассистентах для программирования, подробно рассматривает недостатки перегрузки контекстного окна LLM слишком большим количеством MCP-инструментов. Huntley оценивает, что снятие лимита в 128 инструментов в Visual Studio Code на недавнем мероприятии вызвало широкое замешательство среди разработчиков, многие из которых установили множество MCP-серверов, не понимая их влияния. Он подчеркивает, что каждый инструмент, зарегистрированный в контекстном окне, потребляет токены, что напрямую влияет на производительность модели. Например, инструмент, который отображает файлы и каталоги, потребляет примерно 93 токена. При добавлении нескольких инструментов доступное контекстное окно быстро сокращается, что приводит к ухудшению качества вывода и непредсказуемому поведению [1].

Эта проблема усугубляется отсутствием стандартизации в подсказках и описаниях инструментов. Разные LLM по-разному реагируют на подсказки. Например, GPT-5 становится менее уверенным при встрече с заглавными буквами, в то время как Anthropic рекомендует их использовать для выделения. Эти различия могут привести к непоследовательной работе инструментов и непреднамеренным результатам. Кроме того, отсутствие контроля пространств имен в MCP-инструментах увеличивает риск конфликтов, когда несколько инструментов выполняют схожие функции. Если зарегистрированы два инструмента для отображения файлов, LLM может вызвать один из них непредсказуемо, что вносит недетерминированность в систему [1].

Безопасность — еще одна острая проблема. Simon Willison в своем блоге “The Lethal Trifecta” подчеркивает опасности, связанные с разрешением агентам ИИ взаимодействовать с приватными данными, ненадежным контентом и внешними коммуникациями без мер предосторожности. Huntley расширяет эту тему, ссылаясь на недавнюю атаку на цепочку поставок Amazon Q, когда вредоносная подсказка привела к удалению ресурсов AWS. Он утверждает, что развертывание сторонних MCP-серверов без контроля увеличивает риск подобных инцидентов. В то время как решения первого лица, когда компании разрабатывают собственные инструменты и подсказки, обеспечивают лучший контроль над рисками цепочки поставок [1].

Несмотря на эти сложности, развертывание MCP-серверов стало значительно проще. Такие платформы, как Northflank, теперь предлагают сервисы для создания, развертывания и управления MCP-серверами как безопасными, автоматически масштабируемыми сервисами. Пользователи могут контейнеризировать свой MCP-сервер с помощью инструментов, таких как FastMCP и Starlette, а затем развернуть его с автоматическими проверками состояния и секретами времени выполнения. Эта инфраструктура поддерживает как HTTP/SSE, так и WebSocket-протоколы, обеспечивая гибкость взаимодействия клиентов с сервером [2].

В будущем разработчикам и организациям рекомендуется более стратегически подходить к использованию MCP-серверов. Huntley советует ограничивать количество инструментов в контекстном окне для поддержания производительности и безопасности. Он также рекомендует активировать инструменты только на соответствующих этапах рабочего процесса — например, использовать Jira MCP во время планирования и отключать его после — чтобы минимизировать риски и оптимизировать распределение ресурсов. По мере развития экосистемы стандартизация и лучшие практики станут необходимыми для того, чтобы MCP-серверы способствовали, а не препятствовали продуктивности на базе ИИ [1].

Источник:

Дисклеймер: содержание этой статьи отражает исключительно мнение автора и не представляет платформу в каком-либо качестве. Данная статья не должна являться ориентиром при принятии инвестиционных решений.

Вам также может понравиться

Интервью с инвестиционным менеджером VanEck: стоит ли сейчас покупать BTC с точки зрения институциональных инвесторов?

Поддержка в районе 78 000 и 70 000 долларов является хорошей возможностью для входа.

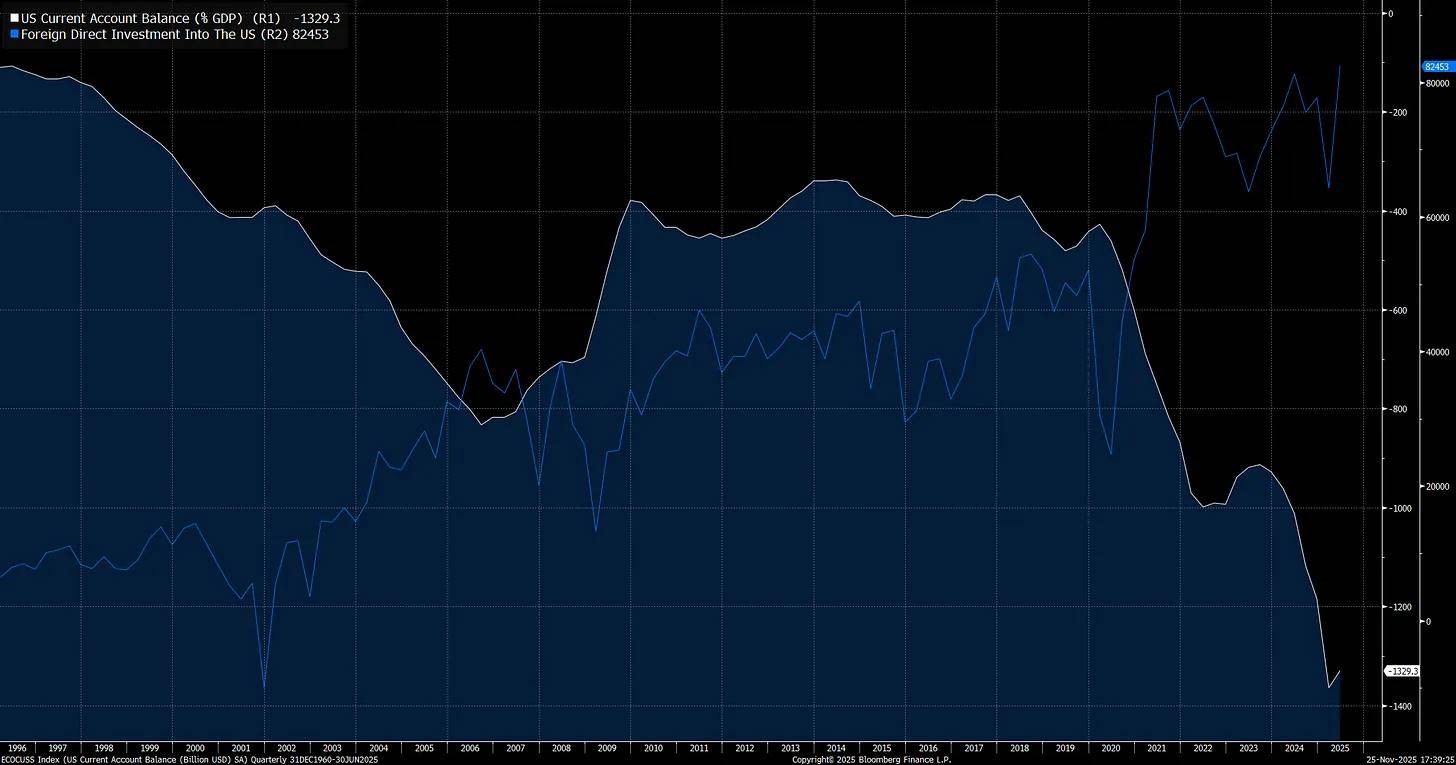

Макроэкономический отчет: как Трамп, ФРС и торговля вызвали самые большие колебания на рынке в истории

Умышленная девальвация доллара сталкивается с экстремальным дисбалансом трансграничных потоков и чрезмерной переоценкой, что создает почву для волатильного события.

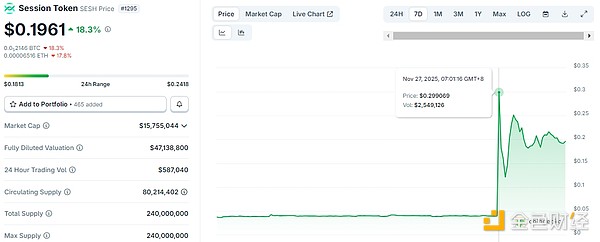

Виталик пожертвовал 256 ETH двум неизвестным чат-приложениям — на что же он делает ставку?

Он ясно отметил: оба этих приложения далеки от совершенства, и чтобы достичь действительно хорошего пользовательского опыта и безопасности, предстоит проделать ещё большой путь.