I legislatori del Regno Unito avvertono: le promesse sulla sicurezza dell'IA stanno diventando solo facciata

- 60 parlamentari britannici accusano Google DeepMind di aver violato gli impegni sulla sicurezza dell’IA ritardando la pubblicazione di report dettagliati sulla sicurezza per Gemini 2.5 Pro. - L’azienda ha rilasciato una scheda modello semplificata tre settimane dopo il lancio, senza trasparenza riguardo ai test di terze parti e al coinvolgimento delle agenzie governative. - Google sostiene di aver rispettato gli impegni pubblicando un report tecnico alcuni mesi dopo, ma i critici affermano che ciò mina la fiducia nei protocolli di sicurezza. - Problemi simili presso Meta e OpenAI evidenziano preoccupazioni diffuse a livello industriale sull’opacità.

Un gruppo di 60 parlamentari del Regno Unito ha firmato una lettera aperta accusando Google DeepMind di non aver rispettato i suoi impegni sulla sicurezza dell’IA, in particolare riguardo al ritardo nella pubblicazione di informazioni dettagliate sulla sicurezza per il suo modello Gemini 2.5 Pro [1]. La lettera, pubblicata dal gruppo attivista politico PauseAI, critica l’azienda per non aver fornito una model card completa al momento del rilascio del modello, un documento chiave che descrive come il modello è stato testato e costruito [1]. Secondo loro, questa mancanza costituisce una violazione degli impegni sulla sicurezza della Frontier AI presi durante un vertice internazionale nel febbraio 2024, dove i firmatari — tra cui Google — si erano impegnati a rendere pubbliche le capacità dei modelli, le valutazioni dei rischi e il coinvolgimento di test di terze parti [1].

Google ha rilasciato Gemini 2.5 Pro nel marzo 2025 ma non ha pubblicato una model card completa in quel momento, nonostante avesse dichiarato che il modello superava i concorrenti nei principali benchmark [1]. Invece, una model card semplificata di sei pagine è stata pubblicata tre settimane dopo, che alcuni esperti di governance dell’IA hanno definito insufficiente e preoccupante [1]. La lettera sottolinea che il documento mancava di dettagli sostanziali sulle valutazioni esterne e non confermava se agenzie governative, come il U.K. AI Security Institute, fossero state coinvolte nei test [1]. Queste omissioni sollevano dubbi sulla trasparenza delle pratiche di sicurezza dell’azienda.

In risposta alle critiche, un portavoce di Google DeepMind aveva precedentemente dichiarato a Fortune che qualsiasi suggerimento secondo cui l’azienda stesse venendo meno ai suoi impegni era "inesatto" [1]. L’azienda ha inoltre dichiarato a maggio che un rapporto tecnico più dettagliato sarebbe stato pubblicato quando la versione finale della famiglia di modelli Gemini 2.5 Pro fosse stata disponibile. Un rapporto più completo è stato infine pubblicato a fine giugno, mesi dopo che la versione completa era stata resa disponibile [1]. Il portavoce ha ribadito che l’azienda sta rispettando i suoi impegni pubblici, inclusi i Seoul Frontier AI Safety Commitments, e che Gemini 2.5 Pro è stato sottoposto a rigorosi controlli di sicurezza, comprese valutazioni da parte di tester indipendenti [1].

La lettera osserva inoltre che la mancanza della model card per Gemini 2.5 Pro sembrava contraddire altri impegni presi da Google, come i White House Commitments del 2023 e un Codice di Condotta volontario sull’Intelligenza Artificiale firmato nell’ottobre 2023 [1]. La situazione non è unica per Google. Anche Meta ha affrontato critiche simili per la sua model card minima e limitata per il modello Llama 4, mentre OpenAI ha scelto di non pubblicare un rapporto sulla sicurezza per il suo modello GPT-4.1, citando il suo status non-frontier [1]. Questi sviluppi suggeriscono una tendenza più ampia nel settore in cui le divulgazioni sulla sicurezza stanno diventando meno trasparenti o vengono omesse del tutto.

La lettera invita Google a riaffermare i suoi impegni sulla sicurezza dell’IA definendo chiaramente il deployment come il momento in cui un modello diventa accessibile al pubblico, impegnandosi a pubblicare rapporti di valutazione della sicurezza secondo una tempistica prestabilita per tutti i futuri rilasci di modelli, e fornendo piena trasparenza per ogni rilascio nominando le agenzie governative e le terze parti indipendenti coinvolte nei test, insieme alle tempistiche esatte dei test [1]. Lord Browne di Ladyton, firmatario della lettera e membro della Camera dei Lord, ha avvertito che se le principali aziende di IA considerano gli impegni sulla sicurezza come opzionali, ciò potrebbe portare a una pericolosa corsa al rilascio di sistemi di IA sempre più potenti senza adeguate misure di sicurezza [1].

Fonte:

Esclusione di responsabilità: il contenuto di questo articolo riflette esclusivamente l’opinione dell’autore e non rappresenta in alcun modo la piattaforma. Questo articolo non deve essere utilizzato come riferimento per prendere decisioni di investimento.

Ti potrebbe interessare anche

Un mercato coperto dalla paura

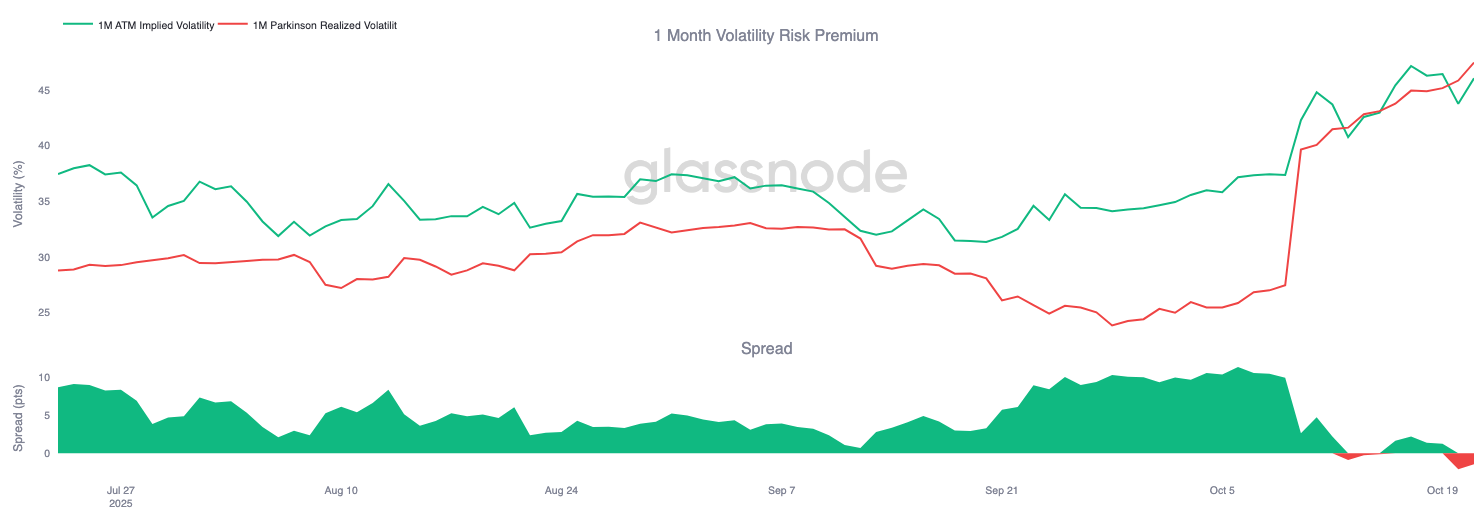

Bitcoin viene scambiato al di sotto dei principali livelli di costo base, segnalando un esaurimento della domanda e una perdita di slancio. I detentori di lungo termine stanno vendendo durante i rialzi, mentre il mercato delle opzioni assume un atteggiamento difensivo, con una crescente domanda di put e una volatilità elevata, indicando una fase di cautela prima di qualsiasi ripresa sostenibile.

Evernorth supportata da Ripple ora possiede ben 261 milioni di XRP

Garantire un enorme tesoro di XRP in vista della quotazione pubblica al Nasdaq tramite la fusione con Armada Acquisition Corp II.

Gli ETF su Bitcoin ed ETH perdono terreno mentre gli investitori tornano su Bitcoin: è finita la stagione delle altcoin?

Cambiamento delle preferenze di mercato: oltre 128 milioni di dollari ritirati dagli ETF su ETH mentre l'attività sui futures di Bitcoin raggiunge livelli record.

La rivoluzione delle stablecoin: quando i pagamenti non dipendono più dalle banche, quanto è alto il soffitto per le startup FinTech?

La Federal Reserve non sta solo esplorando stablecoin e pagamenti AI, ma sta anche testando una nuova proposta chiamata "conti principali semplificati", che consentirebbe alle aziende qualificate di accedere direttamente al sistema di regolamento della Fed, aprendo così nuove porte all’innovazione fintech.