Una nuova frontiera per la sicurezza dell’AI: test incrociati tra laboratori per unire l’industria

- Ilya Sutskever di OpenAI sostiene i test incrociati tra laboratori per rafforzare la sicurezza dell'IA in un contesto di rapidi progressi tecnologici e rischi diffusi nel settore. - Il progetto pilota di Claude di Anthropic, basato su browser, mette in evidenza sfide di sicurezza come gli attacchi di prompt injection, spingendo verso strategie di mitigazione rafforzate. - Uno studio rivela una scarsa conformità agli impegni volontari di sicurezza da parte delle principali aziende di IA, tra cui Apple, mettendo in discussione l’efficacia dell’autoregolamentazione. - L’AI Safety Initiative della Cloud Security Alliance offre framework e RiskRub.

Ilya Sutskever, co-fondatore e membro del consiglio di OpenAI, ha richiesto l'implementazione di test incrociati tra laboratori come misura fondamentale per garantire la sicurezza dei sistemi di intelligenza artificiale (AI). La sua dichiarazione arriva in un momento di crescenti preoccupazioni riguardo ai rischi associati ai progressi dell'AI, con i leader del settore che sottolineano la necessità di protocolli di sicurezza collaborativi e standardizzati. L'appello di Sutskever ai test incrociati tra laboratori si allinea con gli sforzi più ampi per rafforzare la sicurezza dell'AI e mitigare i potenziali danni mentre la tecnologia continua a evolversi rapidamente [1].

La necessità di approcci collaborativi di questo tipo è sottolineata dagli sviluppi recenti nel dispiegamento e nella regolamentazione dell'AI. Ad esempio, Anthropic, un attore importante nel settore dell'AI, ha introdotto un programma pilota per il suo assistente AI, Claude, progettato per operare direttamente nei browser degli utenti. Questa iniziativa, che mira a migliorare l'utilità dell'AI integrandola nei flussi di lavoro digitali principali, ha anche evidenziato le significative sfide di sicurezza associate agli agenti AI basati su browser. Gli attacchi di prompt injection—dove attori malintenzionati manipolano il comportamento dell'AI incorporando istruzioni nascoste—sono emersi come un rischio chiave, spingendo Anthropic a implementare robuste strategie di mitigazione come permessi a livello di sito, conferme delle azioni e classificatori avanzati per rilevare schemi sospetti [2].

Tali rischi non sono limitati alle singole aziende. Un recente studio di ricercatori di Brown, Harvard e Stanford ha rilevato che molte aziende di AI non hanno rispettato pienamente i loro impegni volontari sulla sicurezza, in particolare dopo le promesse sulla sicurezza dell'AI dell'amministrazione Biden nel 2023. Apple, ad esempio, ha ottenuto risultati scarsi nella valutazione, con prove di conformità per solo uno su otto impegni. Lo studio evidenzia i limiti dell'autoregolamentazione in un settore in rapida evoluzione e solleva interrogativi sull'efficacia delle misure volontarie nel garantire responsabilità e sicurezza [5].

In risposta a queste sfide, la Cloud Security Alliance (CSA) ha lanciato la sua AI Safety Initiative alla fine del 2023, riunendo leader del settore, agenzie governative e istituzioni accademiche per sviluppare strumenti pratici e framework per la gestione dei rischi dell'AI. L'iniziativa fornisce alle organizzazioni checklist di preparazione all'AI, framework di governance e linee guida di sicurezza, con l'obiettivo di allineare il progresso tecnologico alle aspettative normative. In particolare, la CSA ha anche introdotto RiskRubric.ai, un sistema di punteggio che valuta la sicurezza, la trasparenza e l'affidabilità dei large language model (LLM), offrendo alle imprese un approccio basato sui dati per l'adozione dell'AI [4].

Gli sforzi collaborativi per migliorare la sicurezza dell'AI sono inoltre supportati da un ecosistema in crescita di finanziatori e programmi di sovvenzione. Organizzazioni come il Long-Term Future Fund, il Survival and Flourishing Fund e l'AI Safety Fund stanno fornendo supporto finanziario a ricercatori, imprenditori e istituzioni che lavorano sulla mitigazione dei rischi dell'AI. Queste iniziative mirano ad affrontare i rischi esistenziali a lungo termine promuovendo al contempo l'innovazione responsabile. Inoltre, società di venture capital come Juniper Ventures e Mythos Ventures stanno investendo in startup che sviluppano strumenti per migliorare la sicurezza, la conformità e la governance dell'AI [6].

L'appello ai test incrociati tra laboratori, come sostenuto da Sutskever, rappresenta un passo fondamentale per affrontare queste sfide sistemiche. Consentendo standard condivisi e valutazioni trasparenti tra i laboratori di sviluppo AI, il settore può favorire una maggiore fiducia e responsabilità. Questo approccio è particolarmente importante man mano che i sistemi AI diventano più complessi e capaci, rendendo necessaria una posizione unificata per valutare i potenziali rischi prima della distribuzione. OpenAI, Anthropic e altri attori chiave hanno l'opportunità—e la responsabilità—di guidare questa transizione adottando protocolli di sicurezza collaborativi e stabilendo un precedente per l'innovazione responsabile dell'AI [1].

Esclusione di responsabilità: il contenuto di questo articolo riflette esclusivamente l’opinione dell’autore e non rappresenta in alcun modo la piattaforma. Questo articolo non deve essere utilizzato come riferimento per prendere decisioni di investimento.

Ti potrebbe interessare anche

Cinque grafici per capire: dove va il mercato dopo ogni tempesta normativa?

Dopo questa stretta regolamentare, si tratta di un imminente crollo o dell'inizio di una nuova fase dopo che tutte le notizie negative sono state assorbite? Analizziamo insieme cinque momenti chiave delle politiche per comprendere la traiettoria dopo la tempesta.

Rassegna mattutina di Mars | Il mercato delle criptovalute rimbalza completamente, bitcoin supera nuovamente i 94.500 dollari; la bozza del "CLARITY Act" dovrebbe essere pubblicata questa settimana

Il mercato delle criptovalute registra un rimbalzo generale, Bitcoin supera i 94.500 dollari, le azioni legate alle criptovalute negli Stati Uniti sono in crescita; il Congresso degli Stati Uniti avanza nella regolamentazione delle criptovalute tramite il "CLARITY Act"; il presidente della SEC afferma che molte ICO non costituiscono transazioni di titoli; le whale detengono numerose posizioni long su ETH con profitti significativi.

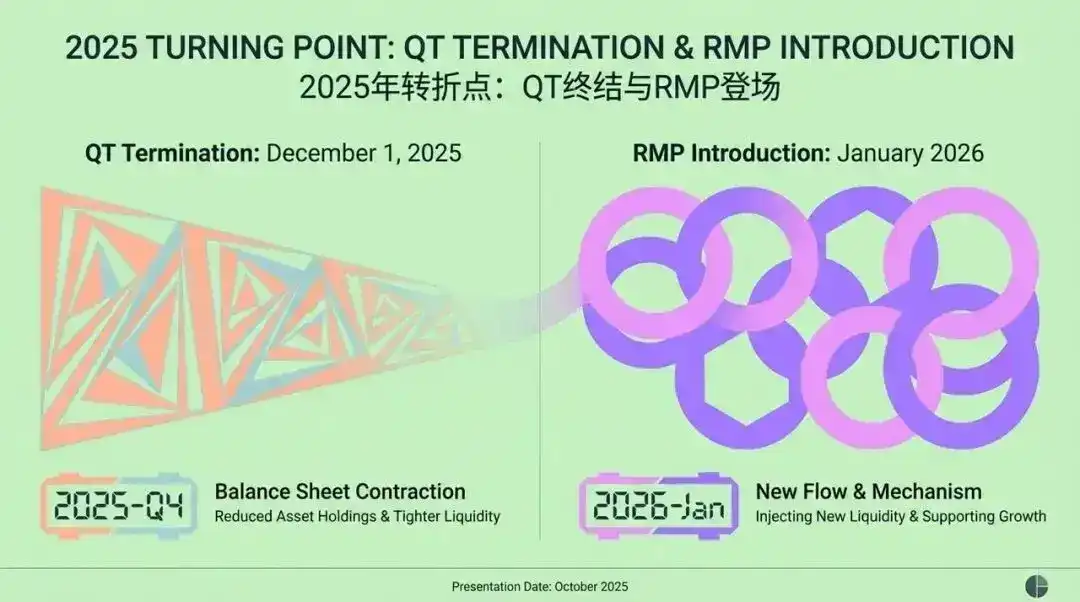

La grande trasformazione della Federal Reserve: dal QT all'RMP, come cambierà radicalmente il mercato entro il 2026?

L'articolo discute il contesto, il meccanismo e l'impatto sul mercato finanziario della strategia Reserve Management Purchase (RMP), introdotta dalla Federal Reserve dopo la fine del Quantitative Tightening (QT) nel 2025. L'RMP è considerata un'operazione tecnica volta a mantenere la liquidità nel sistema finanziario, ma il mercato la interpreta come una politica accomodante velata. L'articolo analizza i potenziali effetti dell'RMP sugli asset rischiosi, sul quadro regolatorio e sulla politica fiscale, fornendo anche raccomandazioni strategiche per gli investitori istituzionali. Riassunto generato da Mars AI. Questo riassunto è stato prodotto dal modello Mars AI, la cui accuratezza e completezza sono in continuo aggiornamento.

Allora integra la rete TRON, portando previsioni decentralizzate basate sull’IA agli sviluppatori